Cloud Management Gateway en Configuration Manager

A partir de la versión 1610, (muy cuestionable) Cloud Management Gateway, algo así como, Puerta de Enlace de Administración en la Nube, proporciona una manera sencilla de administrar clientes de Configuration Manager en Internet.

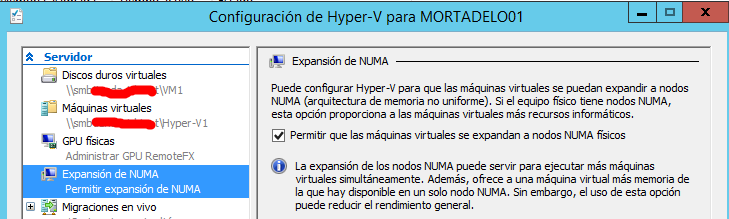

Éste servicio en la nube, (en adelante CMG), se implementa en Microsoft Azure con su suscripción de Azure correspondiente y es el propio SCCM quien publica la configuración de CMG, incluida la información de conexión y la configuración de seguridad.

El propósito es conectar a la infraestructura de SC Configuration Manager local con un nuevo rol denominado, CMG, que viene a sustituir a un descontinuado IBCM.

Una vez implementado y configurado, los clientes podrán tener acceso a los roles de sistema de sitio locales de Configuration Manager independientemente de si están conectados a la red interna privada o a Internet.

CMG autentica y reenvía las solicitudes de cliente de Configuration Manager al punto de conexión de CMG. Estas solicitudes se reenvían a los roles en la red corporativa según las asignaciones de direcciones URL.

Se realiza con una VM en Azure, de tipo Medium

Ésta VM establece un tunel ssl q sirve de proxy desde Azure, lo cual elimina el tedio de configuración en nuestras comunicaciones que requería IBCM de nuestros proxy, firewall o balanceadores.

Junto con ésta funcionalidad, muy recomendable montar otro rol en Azure que se llama Cloud Distribution Point, en adelante CDP, que sirve para distribuir aplicaciones desde un site público en internet y se realiza con una VM de tipo Small.

Con toda ésta configuración hemos de entender que, las 2 VM en Azure generan un tráfico de red, el que sirven a los puestos clientes, que genera un coste de:

- 1 Suscripción en Azure de 2 VM. (1 Small y 1 Medium) Cada instancia de CMG admite 4.000 clientes, con dos instancias daremos mejor disponibilidad.

- 1.000 GB de tráfico. 7 €./mes aprox.

Dicho esto, contemos la realidad de mi experiencia al implementarlo:

Lo primero que tenemos que saber es que necesitamos subir de versión a Configuration Manager, obligatorio trabajar con la versión 1702.

Pero ya adelanto que os dará fallo en AZURE al implementar el rol de CMG Hay dos soluciones, subir a la versión 1706, disponible desde el 29 de agosto de 2017 o aplicar éste hotfix para CMG a la versión 1702:

Los requisitos

Equipos cliente y servidor de sistema de sitio que ejecuten CMG. Antes de poder usar las características de versión preliminar, hay que dar consentimiento para usarlas desde la consola de SCCM para poder seleccionarlas y permitir su uso.

Dar el consentimiento es una acción que se realiza una sola vez por jerarquía y que no se puede deshacer. Mientras no dé su consentimiento, no puede habilitar nuevas características de versión preliminar incluidas con las actualizaciones. Después de activar una característica de versión preliminar, no podremos desactivarla.

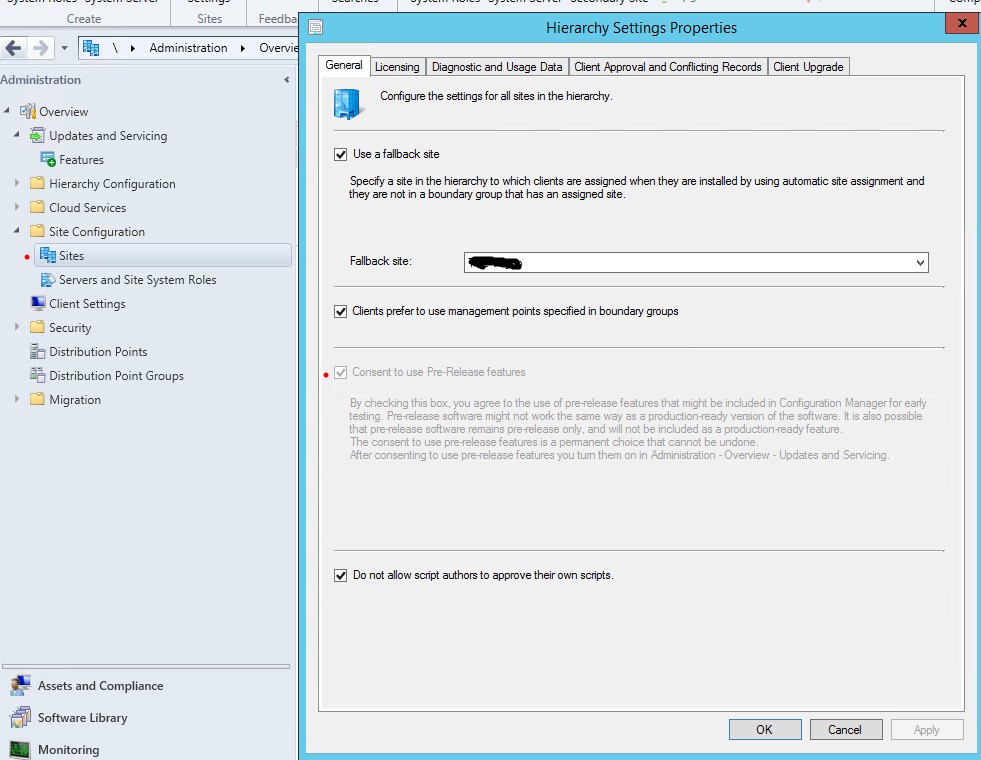

Para dar consentimiento en la consola de SCCM, vamos a Administración –> Configuración del Sitio –> Sitios y seleccionamos, Configuración de jerarquía. En la pestaña General, marcamos, Consent to use Pre-Release features.

Si ha dado su consentimiento ahora puede habilitar las características de versiones preliminares en el Asistente de actualizaciones y mantenimiento al instalar la actualización.

Previamente habremos generado 4 Certificados Web Server SSL personalizados en 2048 desde la CA interna y tener a mano el CA Root de nuestra PKI

Los certificados se usan para cifrar la comunicación de los equipos cliente y para autenticar la identidad del servicio de CMG:

Certificado Admin Azure

- PFX (con clave privada): Para SCCM CB

- CER (solo clave publica): Para Azure

Certificado CMG

- PFX: Para Azure (a través de SCCM CB)

Certificado CDP

- PFX: Para Azure (a través de SCCM CB)

La Implementación

Abrimos la consola de SCCM CB para implementar el servicio en Azure y agregamos el rol de CMG en Cloud Services:

Como se podrá observar en los próximos cinco pasos, la implementación de CMG y DP en SCCM y Azure se realiza obligatoriamente mediante el uso de certificados.

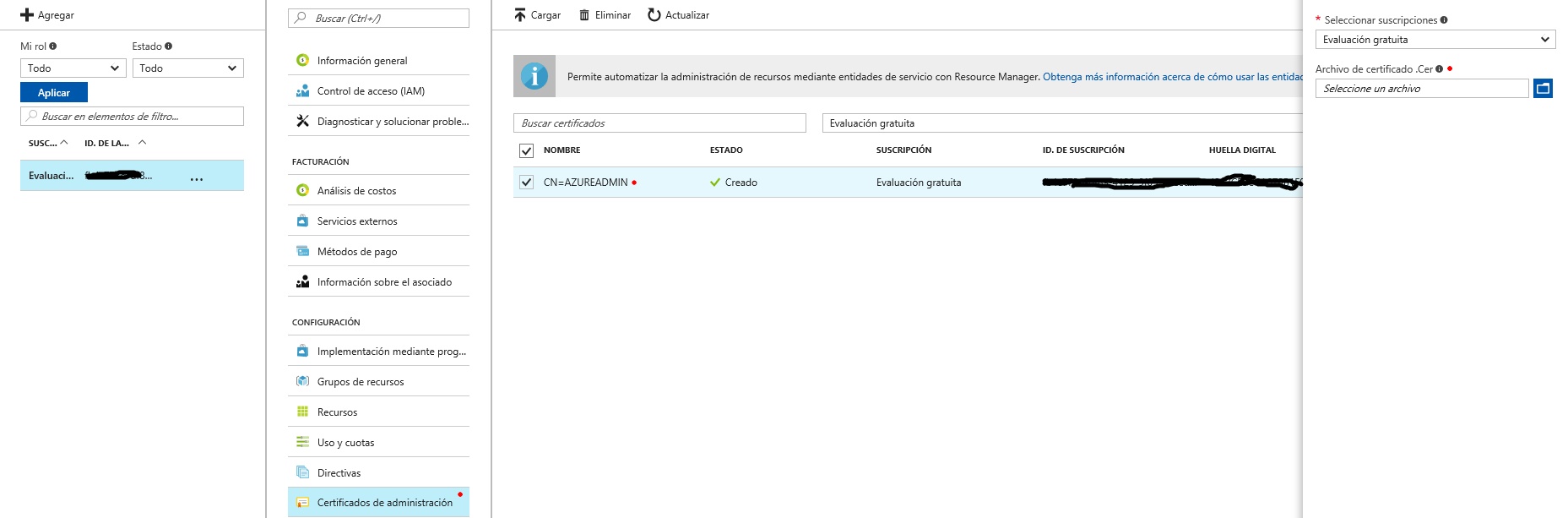

1.- Subir el Certificado de Admin Azure

Éste certificado es necesario para la suscripción en Azure, al cual he llamado, AzureAdmin.cer

2.- AzureAdmin.pfx (Para autenticar la conexión con SCCM y siempre con la terminación cloudapp.net)

2.- AzureAdmin.pfx (Para autenticar la conexión con SCCM y siempre con la terminación cloudapp.net)

El ID de suscripción lo obtenemos de AZURE y utilizaremos el Certificado de Administración al que hemos llamado, AzureAdmin.pfx al crear tanto el Cloud Management Point, como al crear Cloud Distribution Point

Desmarcar comprobación de revocación de certificados y especificamos como Certificado pfx, generado por nuestra PKI. el que hemos llamado CMGMiEmpresa.pfx especificando el servico FQDN con la terminación, cloudapp.net

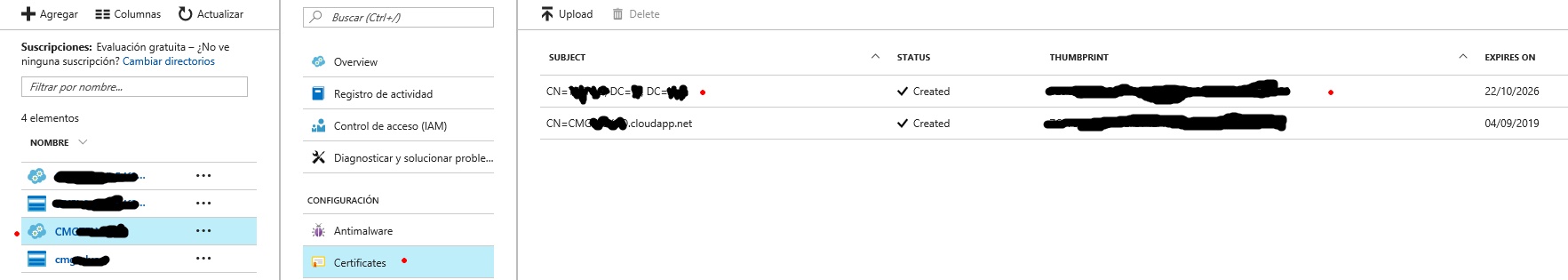

Pinchar sobre Certicados de la CRL y añadir el CA Root de nuestra PKI

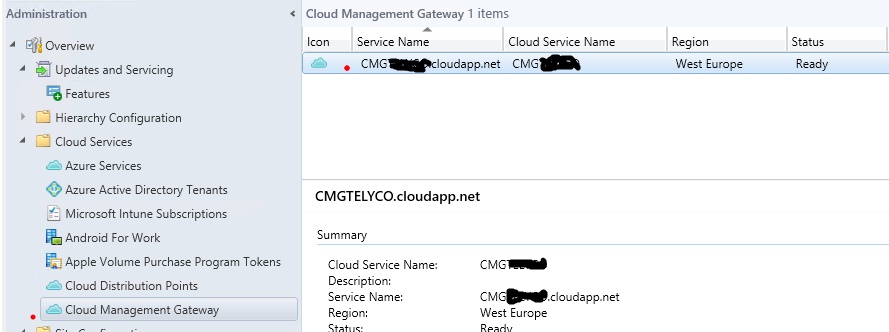

El resto, next, next…de tal forma que en la consola de SCCM nos quedará CMG algo así:

3.- CARoot.cer

(En la VM de Azure para CMG. Necesario para la revocación de certificados que previamente ya hemos desmarcado)

4.- CMG.pfx

Éste Certificado para Azure a traves de SCCM CB, lo hemos utilizado ya en el Punto 2

5.- DP.pfx

La misma idea, que en los Puntos 2 y 5.

El mismo ID de suscripción que obtenemos de AZURE con el Certificado de Administración, AzureAdmin.pfx

En ésta pantalla especificamos como Certificado pfx, el generado por nuestra PKI. el que hemos llamado DPMiEmpresa.pfx

En SCCM, todas las opciones del cliente se administran desde el nodo Configuración de cliente del área de trabajo Administración de su consola.

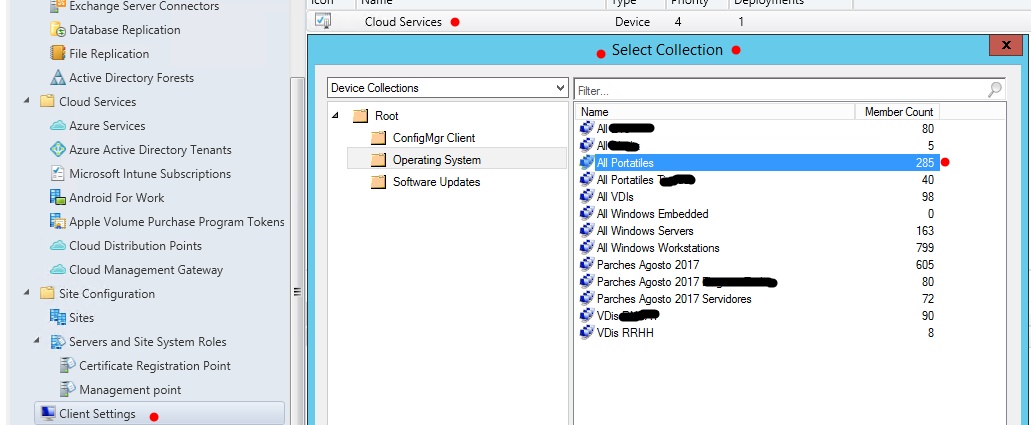

A continuación, vamos a configurar la opción Cloud Services para los dispositivos de alguna colección dentro de nuestra jerarquía y la implementaremos sobre las recopilaciones.

Sobre el Custom Device Settings de Cloud Services que recién hemos creado, botón derecho y seleccionamos Deploy para seleccionar una colección sobre la que implementarlo.

Finalmente decir que existe un bug en la versión 1706, en el componente de notificaciones online del cliente, el cual, aunque esté conectado y exista comunicación, aparece como apagado y no será hasta la reléase 1710 que Microsoft dará solución a ese bug.

Comentarios recientes