Migración del Frontal de Lync Server 2010 a Lync Server 2013

En éste artículo no se explica como instalar Lync Server 2013, sino como mover el rol de Administración Central de Lync Server 2010 a Lync Server 2013 y como poder eliminar nuestro viejo front end de Lync Server 2010.

Lo primero y preferiblemente en un servidor dedicado como frontal de Lync, instala Windows 2012 Server en su versión Standard… también es posible sobre W2K8R2SP1, añade los requisitos Windows para Lync, en la forma de características del OS e instala Lync Server 2013.

Tras la instalación observamos que nuestro nuevo servidor se ha unido a la topología de Lync 2010, pero aun hay que mover el servidor de administración central que reside en Lync Server 2010 al servidor front-end 2013 si queremos como es lógico, quitar el servidor Lync Server 2010 heredado. A partir de aquí éste documento indica los pasos a seguir para migrar el servidor de administración central a Lync Server 2013.

Preparación de los servidores Front-End Lync 2013 antes de mover el Servidor de Administración Central.

A continuación, trato de detallar los pasos a seguir para preparar los servidores de Front-End, antes de mover el servidor de administración central de Lync Server 2010 a Lync Server 2013.

Para preparar un pool de servidor/es Front-End.

Para preparar el pool de servidores Front-End habrá que iniciar sesión, con un usuario con permisos administrativos y de sysadmin de base de datos SQL, en el equipo donde esté instalado como miembro del grupo RTCUniversalServerAdmins la consola de PowerShell de administración de Lync Server. Una vez dentro, se ejecutará una consola de PowerShell de administración de Lync Server. Cuando la ventana aparezca y cargue los comandos, se escribirá el siguiente comando:

Install-CsDatabase -CentralManagementDatabase -SQLServerFQDN -SQLInstanceName

Una vez ejecutado, habrá que comprobar que el estado del servicio Lync Server Front-End esté Iniciado.

Mover el servidor de administración central de Lync Server 2010 a Lync Server 2013

A continuación se detallan los pasos a seguir para realizar el movimiento del servidor de administración central de Lync Server 2010 a Lync Server 2013.

En el servidor Lync Server 2013, que será el nuevo servidor de administración central, habrá que iniciar sesión con un usuario con privilegios de administración y de administración de base de datos SQL. Dentro del servidor, la consola de PowerShell de administración de Lync Server estará instalada como miembro del grupo RTCUniversalServerAdmins. Una vez se haya logado dentro del equipo, habrá que abrir una consola de PowerShell de administración de Lync Server. En ella escriba el siguiente comando:

Enable-CSTopology

Es importante que el comando se ejecute correctamente, ya que en caso contrario, se producirá un error en la migración que puede dejar la topología sin ningún almacén de administración central. Si el comando no se ejecuta correctamente, solucione el problema evitando que el comando se complete antes de continuar.

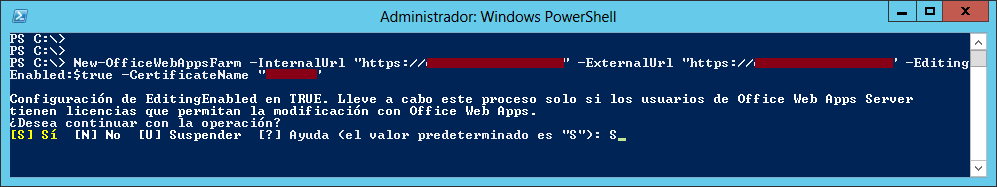

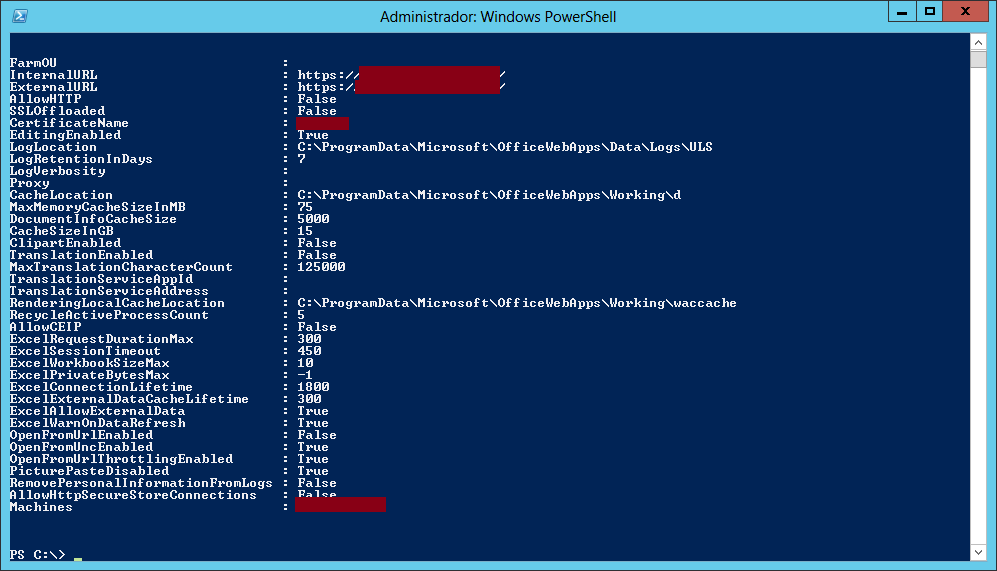

Ahora, habrá que acceder al servidor Front-End o al pool de servidores Front-End y en un PowerShell de administración de Lync Server, habrá que escribir el siguiente comando:

Move-CSManagementserver

En la consola, se mostrarán los servidores, almacenes de archivos, almacenes de bases de datos y puntos de conexión de servicio del estado actual y el estado propuesto. Se leerá la información cuidadosamente para confirmar que el origen sea nuestro antiguo y todavía activo servidor de Lync Server 2010 y el destino el nuevo servidor con Lync Server 2013. Una vez se compruebe que todo es correcto, se escribirá ‘S’ para continuar o, en caso de que haya algún error, ‘N’ para detener la migración.

Una vez finalizada la migración, se revisarán si hay advertencias o errores que se hayan generado al ejecutar el comando move-CsManagementServer, con la intención de resolverlo lo antes posible para poder continuar con el proceso. Hecho esto, en el servidor Lync Server 2013, se abrirá el asistente para la implementación de Lync Server. Una vez abierto. Habrá que pulsar sobre “instalar o actualizar el sistema Lync Server”- Instalar o desinstalar componentes de Lync Server. Después, se hará clic en siguiente, entonces, se abrirá una pantalla de resumen. Una vez leído y revisado, se hará clic en el botón Finalizar para terminar.

El siguiente paso será ir al servidor Lync Server 2010 y abrir el asistente para la implementación de Lync Server. Hecho esto. Habrá que ir, como en la vez anterior, a Instalar o actualizar Lync Server, que se puede encontrar en el mismo sitio. Instalar o desinstalar componentes de Lync Server. Hecho esto, se pulsará en siguiente para continuar. Entonces, aparecerá una página de resumen, se revisará que todo esté correcto y para terminar, se hará clic sobre el botón Finalizar.

Para confirmar que se está efectuando la replicación con el nuevo almacén de administración central, en una consola de Powershell de administración de Lync Server, escriba:

Get-CSManagementStoreReplicationStatus

Es muy posible, que la replicación necesite bastante tiempo para actualizar todas las réplicas.

Quitar archivos de Lync Server 2010 del almacén de administración central después del movimiento.

Antes de realizar este paso. La replicación tiene que haber finalizado por completo y estar estable. Ya que si quita los archivos antes de completar la replicación, se interrumpirá el proceso de replicación y el servidor de administración central migrado quedará en un estado desconocido. Para comprobar y confirmar el estado de la replicación, en una consola de PowerShell de administración de Lync escribir el comando Get-CSManagementStoreReplicationStatus.

Una vez haya finalizado el movimiento del almacén de administración central, habrá que quitar los archivos del servidor Lync Server 2010. Para ello, habrá que seguir los siguientes pasos.

Se accederá al servidor Lync Server 2010 y se iniciará sesión con un usuario con permisos de administración de base de datos SQL Server. Se abrirá una consola de Powershell de administración de Lync Server y se ejecutará el siguiente comando:

Uninstall-CsDatabase -CentralManagementDatabase -SqlServerFqdn <FQDN of SQL Server> -SqlInstanceName <Name of source server>

Donde el <FQDN of SQL Server> es el servidor Back-End de Lync Server 2010 en una implementación de Enterprise Edition o el FQDN del servidor Standard Edition. Quedaría de la siguiente manera:

Uninstall-CsDatabase –CentralManagementDatabase –SQLServerFQDN Servidor – InstanceName Lync2010

Una vez replicados los cambios, podremos apagar nuestro viejo front end de Lync Server 2010.

Comentarios recientes