TEAM en Windows Server 2012

Como ya expusimos en otro post de éste blog, Windows Server 2008 R2 soporta y admite configuración Teaming en las NIC de nuestro hardware, con el siempre condicionante de que dependía de los fabricantes de NIC el desarrollo del software de Team.

En Windows Server 2012, el Team es ahora nativo del sistema operativo, independientemente del fabricante que se encuentre en nuestro CPD.

Hay tres grandes aspectos que destacan en la solución de Team.

- Poder asociar Team NICs para el tráfico de red normal o para el entorno virtual.

- Poder trabajar en Team con NICs de diferentes fabricantes.

- Poder formar Team de hasta 32 tarjetas de red en un solo equipo.

Veamos la interfaz de usuario y las opciones que tenemos disponibles.

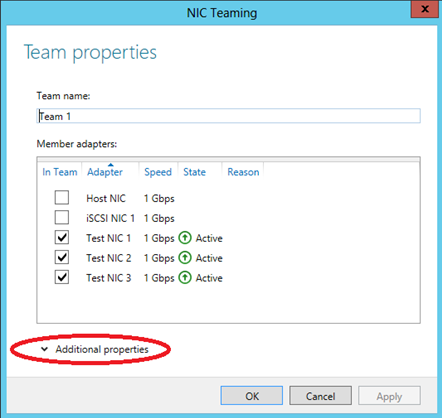

En ésta imagen muestro una configuración de NIC Teaming nativa a Windows Server 2012 y quería resaltar algunos de los puntos de interes de éste nuevo concepto de Team.

Evidentemente necesitamos al menos dos tarjetas de red para crear un equipo y notar que podemos trabajar en un servidor con un máximo de 32 NICs. La creación de un grupo de NIC es muy fácil y personalmente me gusta porque el proceso de instalación respeta los nombres que se colocan en las NICs.

Una vez creado el grupo de NIC, al que he llamado Team 1, podemos seleccionar las NICs que formarán parte de ese Team.

Si ampliamos las propiedades adicionales podremos realizar cambios de configuración en base a la parametrización de red individual que necesitemos y debemos tener opciones para configurar nuestro Team más alla de conformarnos con una configuración estática del tipo; «One Size Fits All».

Como vemos en la imagen de arriba, as propiedades del Team, proporcionan una lista de todas las tarjetas disponibles en el servidor. Aquí podremos elegir qué tarjetas de red deseamos añadir a nuestra configuración de Team.

El nombre que he dado a mis tarjetas de red es uno muy al uso en laboratorios como el mío, «Test NIC 1,» Test NIC 2, y «Test NIC 3» y el Team se llama «Team 1».

A partir de aquí se presentan los detalles adicionales que se pueden configurar para nuestro Team, lo cual nos va a permitir ser muy específicos acerca de cómo el Team, equilibra la carga y se conecta a la red.

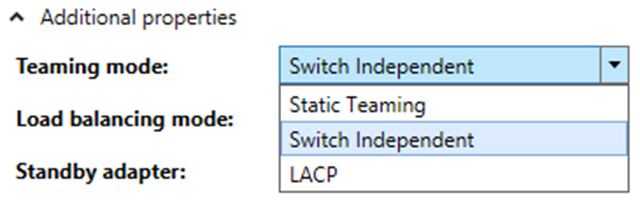

MODO TEAMING

Como podemos ver en la imagen el Team se puede configurar para trabajar en Team estático, en modo switch independiente, o LACP (Link Aggregation Control Protocol).

Static Teaming requiere configuración tanto en el switch como en el servidor para identificar los vínculos que formaran el Team. Este modelo de Team nos ofrece un switch dependiente del Teaming que formemos con nuestras NICs.

Switch Independent El modo independiente nos permite distribuir las tarjetas de red en el Team a través de múltiples conmutadores de red ó (Network Switches) en nuestro entorno.

LACP proporciona (Link Aggregation) que podríamos traducir como, la agregación de enlace y además permite la expansión y la reducción del grupo de NIC. Este es un modo de swith ó conmutación independiente del NIC Teaming.

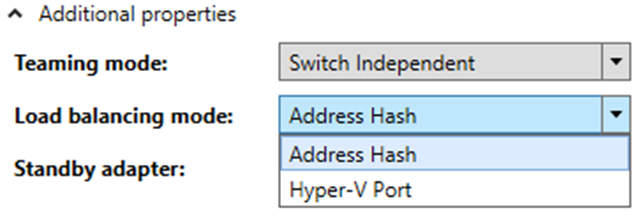

MODO LOAD BALANCING:

Las opciones son o bien Address Hash o Hyper-V Port.

Address Hash es la forma de configurar el Team para el tráfico NLB (network load balancing) entre las NIC que forman el Team.

Hyper-V Port balancea la carga para equilibrar el tráfico que pasa por la VM.

Con Hyper-V Port, la buena noticia es que, las transacciones de cada VM tienen una tarjeta de red por separado, con la desventaja de que que cada máquina virtual sólo puede realizar transacciones a través de una tarjeta de red única. Si tienes varias tarjetas de red virtuales en la máquina virtual y se forma un team para ellas, el Hyper-V Port puede ser la mejor opción.

Para la mayoría de las configuraciones, es muy posible que la Address Hash sea la mejor opción para que la máquina virtual pueda acceder a la red, aún en el caso de que la tarjeta de red de la máquina virtual está dando fallo. Recordemos que con la tecnología Hyper-V Port, un fallo de la NIC de la máquina virtual está causando una interrupción de la comunicación entre, la máquina virtual y la red. Con Address Hash no tendremos éste problema.

STANDBY ADAPTER Ó ADAPTADOR EN ESPERA:

Como bien define su nombre, ésta solución nos permite definir un adaptador de reserva para el equipo. Hay que tener en cuenta que sólo se puede definir un adaptador de espera y además se puede asegurar que el ancho de banda asociado estará disponible incluso si una tarjeta de red de nuestro Team falla.

Fijémonos en las conexiones de red que se nos han formado. Team 1 es una asociación de NICs y notar también que las NIC agrupadas son de diferentes fabricantes.

Comentarios recientes